Nvidia ouvre ses GPU à la technologie mémoire de nouvelle génération de Samsung

Nvidia aurait donné son feu vert à l’utilisation des puces mémoire avancées de Samsung dans ses produits, selon MT Newswires, ce qui marque une étape clé pour le géant coréen dans l’industrie des semi-conducteurs et mettant en lumière l’importance croissante des technologies de mémoire pour les accélérateurs d’IA.

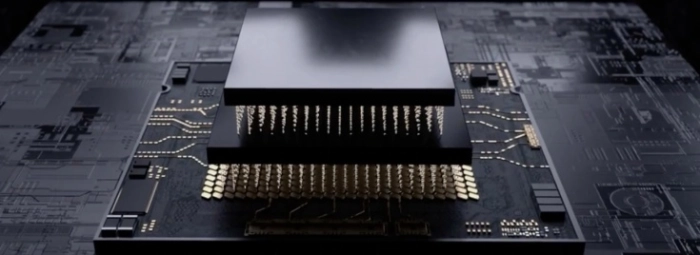

Après plusieurs tentatives et plus d’un an de tests, Samsung a obtenu l’approbation de Nvidia pour sa mémoire HBM3E à 12 couches, une composante essentielle des cartes accélératrices d’intelligence artificielle de nouvelle génération, telles que les GPU dédiés au calcul exascale. Cette validation ouvre à Samsung la possibilité de concurrencer directement SK Hynix et Micron, ses principaux rivaux sur ce marché technologique haut de gamme

Enjeux technologiques autour de la HBM3E

La mémoire HBM3E de Samsung se distingue par sa capacité à empiler 12 couches, augmentant la bande passante et la performance thermique nécessaires pour répondre aux exigences des modèles d’IA de pointe. Nvidia avait longtemps privilégié la stabilité et la performance des solutions proposées par SK Hynix, mais les récents progrès techniques réalisés par Samsung (engagés notamment par une refonte pour résoudre les problèmes thermiques) ont permis de franchir ce cap d’exigence

Bien que l’impact immédiat soit mesuré, la majorité des commandes Nvidia restant allouées à SK Hynix et Micron pour cette année, Samsung bénéficie désormais d’un accès au cercle restreint des fournisseurs de mémoire haute performance pour l’IA. Cela positionne l’entreprise pour une montée en puissance avec la génération HBM4, dont les livraisons massives pourraient débuter dès 2026.

Les implications pour Nvidia et l’innovation IA

Pour Nvidia, diversifier son approvisionnement en mémoire ultra-rapide est stratégique dans le contexte de l’explosion de la demande liée à l’IA générative et aux infrastructures de calcul intensif. Cette ouverture à Samsung renforce la résilience de sa chaîne d’approvisionnement tout en accélérant l’intégration de technologies innovantes, comme les nœuds de fabrication avancés (3nm/2nm) et les futures générations de puces dédiées à l’IA.

Le marché de la mémoire HBM connaît une croissance annuelle projetée de 30% jusqu’en 2027, portée par les besoins en bande passante pour les centres de données et l’intelligence artificielle. L’approbation officielle de la HBM3E par Nvidia redonne confiance aux investisseurs sur la capacité de Samsung à rivaliser avec les leaders, tout en stimulant sa valorisation en Bourse. Les prochains défis porteront sur la mise en production à grande échelle et l’arrivée de la HBM4, qui promet des progrès technologiques majeurs.